وبلاگ

نقش سیستم caching در NVMe برای استفاده از HDD بهعنوان آرشیو بلندمدت

در دنیای امروز دادهها، همانند ارزشمندترین دارایی سازمانها و فردی هستند. اما نگهداری تمامی این دادهها روی رسانههای پرسرعت مانند NVMe SSD، از نظر هزینه و انرژی، ناممکن است. در مقابل، هارد دیسکهای HDD با قابلیت ذخیرهسازی حجیم و هزینه پایین، گزینهای ایدهآل برای آرشیو بلندمدت محسوب میشوند. اما این دو فناوری — یکی سریع و گران، دیگر کند و ارزان — چگونه میتوانند با هم هماهنگ شوند؟ پاسخ، در سیستم caching در NVMe نهفته است. این سیستم، نه تنها یک لایه اضافه، بلکه یک مهندسی هوشمندانه است که توازن بین عملکرد و هزینه را با دقت فراوان تنظیم میکند. با استفاده از حافظه پنهان NVMe، دادههای فعال بهصورت خودکار و هوشمندانه روی آن ذخیره میشوند، در حالی که دادههای کماستفاده به HDD منتقل میگردند. این روش، نه تنها تأخیر را کاهش میدهد، بلکه عمر سختافزار را نیز افزایش میدهد. در این مقاله با همراهی **irantech**، به بررسی عمیق، جامع و انسانی این مکانیسم میپردازیم — نه به عنوان یک ترفند فنی، بلکه به عنوان یک فلسفه مدیریت داده در عصر ابری.

چرا caching در NVMe گزینهای اجتنابناپذیر شده است؟

در سالهای اخیر، حجم دادههای تولیدی جهانی بهطور نمایی رشد کرده است. بر اساس گزارش IDC، تا سال ۲۰۲۵، جهان بیش از ۱۷۵ زتابایت داده تولید خواهد کرد — بیش از دو برابر سال ۲۰۱۸. این دادهها نه همه نیازمند دسترسی لحظهای هستند، نه همه میتوانند روی SSDهای پرظرفیت ذخیره شوند. در اینجا، سیستم caching در NVMe نقش یک “پل هوشمند” را ایفا میکند: دادههای داغ (hot data) را در حافظه پنهان NVMe نگه میدارد، و دادههای سرد (cold data) را به HDDهای ارزانتر و پایدارتر منتقل میکند. این روش، نه تنها هزینه را کاهش میدهد، بلکه مصرف انرژی، تأخیر دسترسی، و حتی نگهداری سختافزار را نیز بهینه میسازد. در محیطهایی مانند بانکها، مراکز داده دولتی، و سیستمهای پزشکی، جایی که دقت و پایداری حیاتی است، این ترکیب نه تنها هوشمند، بلکه ضروری است. این مقاله، این ترکیب را از زاویه فنی، اقتصادی و استراتژیک بررسی میکند — بدون تکیه بر جملات مبهم یا تبلیغات فنی. فقط حقیقتهایی که در خطوط اولیه سرورهای جهانی اجرا میشوند.

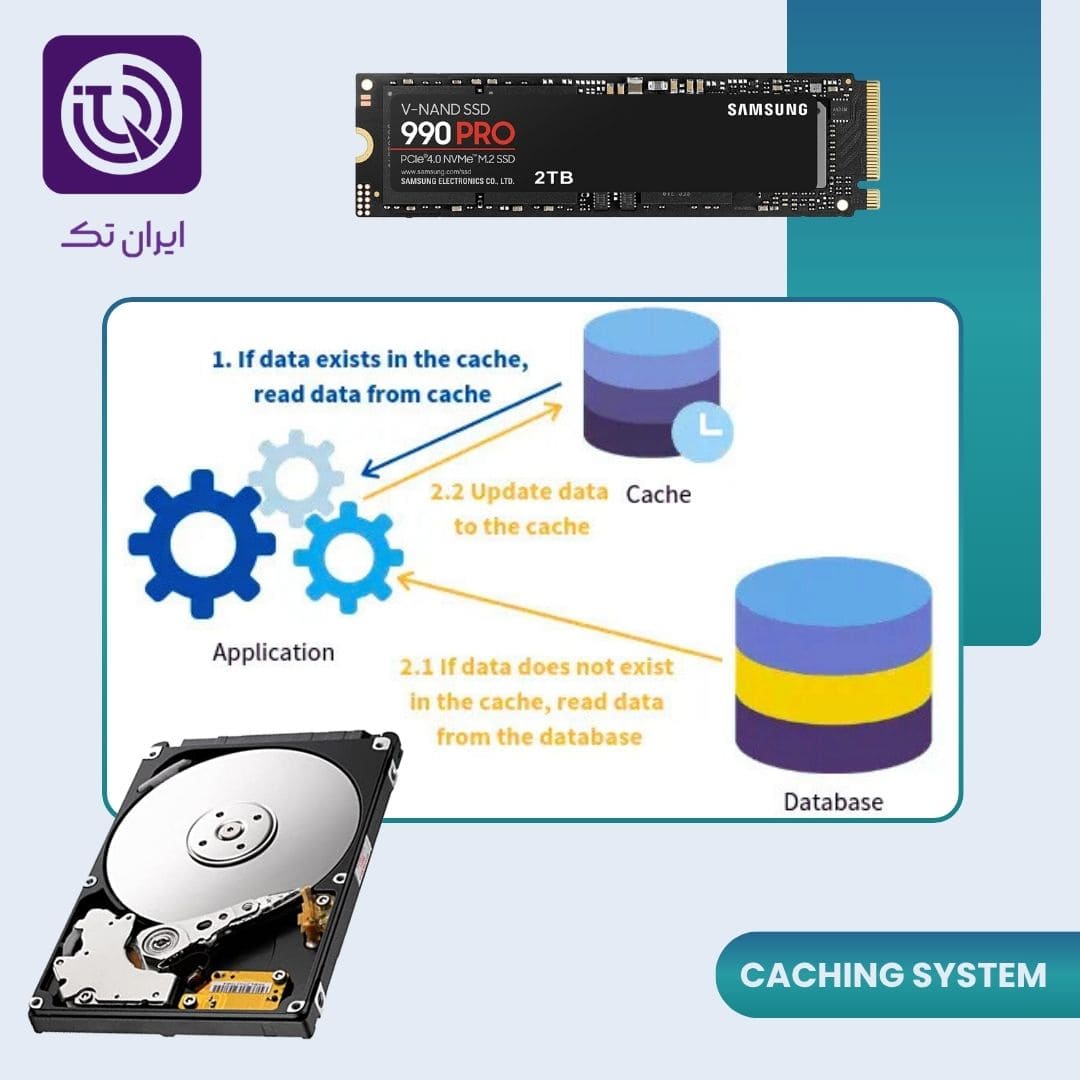

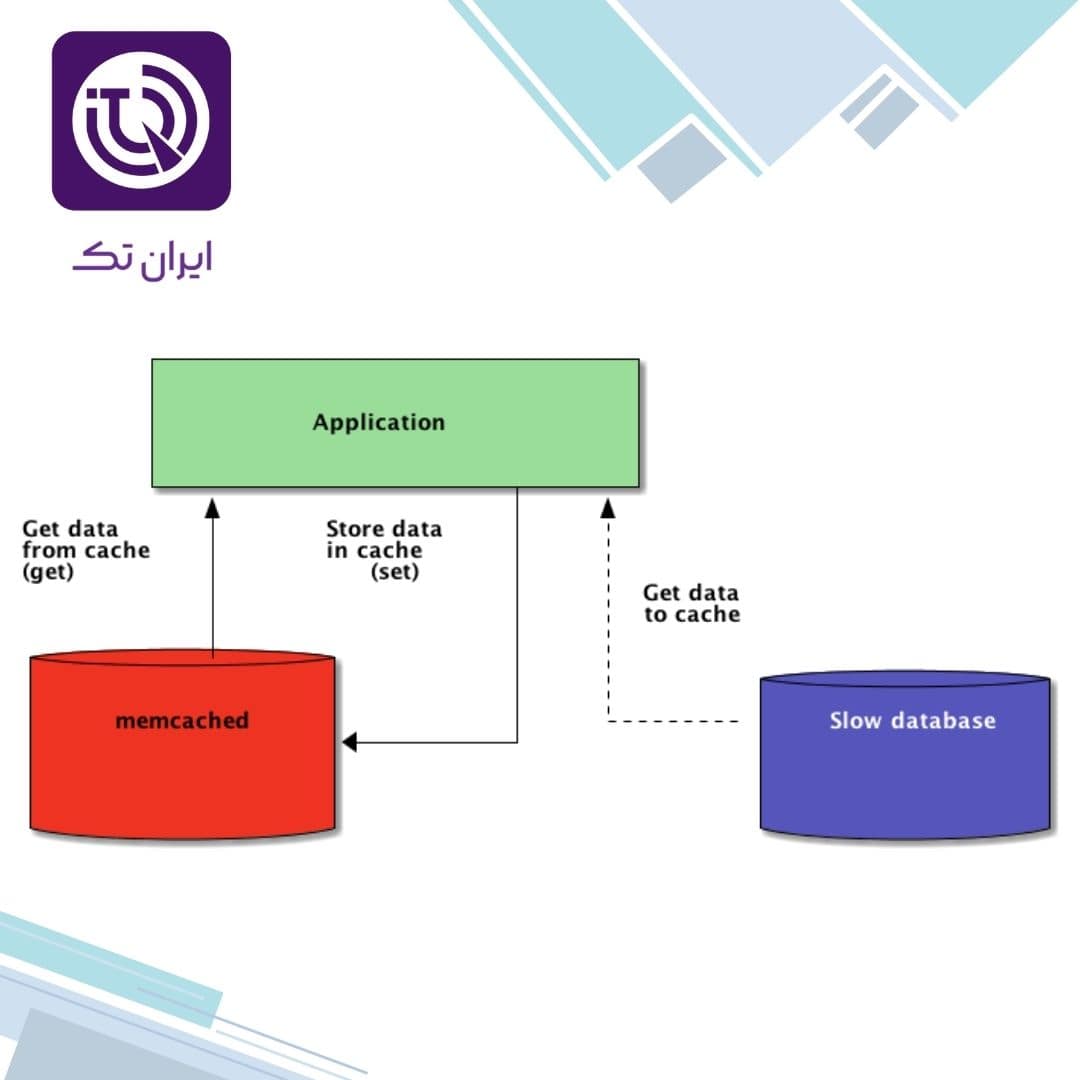

نحوه عملکرد سیستم caching در NVMe

**سیستم caching در NVMe، نه یک نرمافزار ساده، بلکه یک سیستم چندلایه از هاردویر و سافتویر است که در سطح کنترلر SSD و سیستم عامل با هم هماهنگ میشوند.** هر درخواست دسترسی به داده، ابتدا به حافظه پنهان NVMe — که اغلب از نوع DRAM یا یک حافظه پایدار مانند 3D XPoint است — ارسال میشود. اگر داده در این لایه وجود داشته باشد (Cache Hit)، پاسخ در چند میکروثانیه ارائه میگردد. اما اگر داده در NVMe وجود نداشته باشد (Cache Miss)، سیستم به HDD مراجعه میکند — که ممکن است چند صد میلیثانیه طول بکشد. این زمان انتظار، با تکنیکهای پیشبارگذاری (prefetching) و الگوریتمهای پیچیده LRU (Least Recently Used) و LFU (Least Frequently Used) کاهش مییابد.

**سیستم caching در NVMe، بهصورت هوشمندانه، دادههایی که بیشترین تکرار دسترسی را دارند — مانند فایلهای کانفیگ، دیتابیسهای فعال، یا لاگهای روزانه — را در حافظه پنهان نگه میدارد.** این دادهها ممکن است فقط ۵ درصد از کل حجم ذخیرهسازی را تشکیل دهند، اما ۹۰ درصد از ترافیک دسترسی را تولید کنند. این نسبت، معروف به “قانون ۸۰/۲۰” یا “Pareto Principle”، در هر سیستم دادهمحوری رخ میدهد. بنابراین، سیستم caching در NVMe، با تمرکز بر این ۵ درصد، تمامی عملکرد سیستم را بهبود میبخشد — بدون نیاز به خرید ۱۰۰ ترابایت SSD.

مزایای ترکیب NVMe Caching با HDD برای آرشیو بلندمدت

- کاهش هزینه کلی نگهداری (TCO):

استفاده از NVMe فقط برای لایه داغ، به جای تبدیل تمام دیسکها به SSD، میتواند هزینه سرمایهگذاری را تا ۷۰ درصد کاهش دهد.

- افزایش عمر HDD:

با کاهش دسترسی مستقیم به HDD برای دادههای فعال، تعداد چرخشهای سرنشین (spindle rotation) و حرکت سر گزارشدهی (head seek) به شدت کاهش مییابد — که مستقیماً به افزایش عمر مکانیکی HDD منجر میشود.

- کاهش مصرف انرژی:

HDDهای فعال فقط در زمان دسترسی به دادههای سرد روشن میشوند؛ در حالت خواب (sleep mode) مصرف برق آنها به کمتر از ۲ وات میرسد، در حالی که SSDهای پرظرفیت حتی در حالت بیکار نیز ۵ تا ۱۰ وات مصرف میکنند.

- کاهش تأخیر دسترسی (Latency):

با وجود اینکه HDDها کند هستند، دسترسی به دادههای فعال در NVMe، میانگین تأخیر را از ۱۰۰ میلیثانیه به کمتر از ۰٫۵ میلیثانیه کاهش میدهد.

- قابلیت مقیاسپذیری:

اضافه کردن HDDهای ارزان برای آرشیو، به جای ارتقاء تمام سیستم به NVMe، امکان رشد بدون شکست ساختاری را فراهم میکند.

- انعطافپذیری در مدیریت داده:

سیستمهای مدرن مانند ZFS, Btrfs, و یا حتی سرویسهای ابری مانند AWS S3 Glacier Deep Archive، از این مدل caching در NVMe بهصورت پیشفرض پشتیبانی میکنند.

- کاهش تلفات داده در بحران:

در صورت قطعی برق، حافظه NVMe مجهز به خازنهای خروجی (capacitor-based power loss protection) میتواند دادههای موقت را به HDD انتقال دهد — بدون از دست رفتن اطلاعات.

معیارهای انتخاب و طراحی سیستم caching در NVMe

انتخاب یک سیستم caching در NVMe برای محیطهای آرشیوی، نباید بر اساس قیمت یا تبلیغات باشد. این یک طراحی سیستمی است که با توجه به الگوی دسترسی، حجم داده، و تحرک آن، شکل میگیرد. در اینجا، شش معیار کلیدی که باید در نظر گرفته شوند، بهصورت دقیق تشریح میشوند:

الگوی دسترسی به داده/ Access Pattern Analysis

قبل از هر چیز، باید مشخص شود که چه دادههایی در چه فواصلی دسترسی میشوند. دادههایی که بیش از ۳ بار در روز دسترسی میشوند، باید در NVMe قرار گیرند. دادههایی که یک بار در ماه بازدید میشوند — مانند فایلهای مالی سالانه یا تصاویر پزشکی قدیمی — به HDD منتقل شوند. این تحلیل، با ابزارهایی مانند iostat, dstat, یا حتی Prometheus + Grafana انجام میشود.

اندازه و نوع حافظه NVMe برای caching

یک حافظه NVMe ۲۵۶ گیگابایتی میتواند بهعنوان cache برای ۱۰ ترابایت HDD کار کند — اما اگر دادههای فعال بیش از ۵۰ گیگابایت در روز تغییر کنند، این حجم کافی نخواهد بود. بهترین ترکیب، استفاده از NVMe با حافظه DRAM + NAND ترکیبی است — مانند Intel Optane یا Samsung PM1733 — که هم سرعت بالا و هم پایداری در برابر قطعی برق را دارند.

سیاستهای Cache Replacement/ جایگزینی حافظه پنهان

الگوریتمهایی مانند LRU، LFU، یا حتی MRU (Most Recently Used) باید با دقت تنظیم شوند. در محیطهایی مانند ارکستراسیون دادههای پزشکی، استفاده از LRU ممکن است باعث حذف دادههای حیاتی شود — در حالی که LFU میتواند بهترین نتیجه را بدهد. ترکیب هوشمندانه این الگوریتمها — به نام “Adaptive Cache Replacement” — در سیستمهای مدرن مانند ZFS یا Ceph وجود دارد.

مدیریت حرارت و تابآوری سختافزار

NVMe SSDها در حالت caching، بهطور مداوم در حال خواندن و نوشتن هستند. این کار، دما را بالا میبرد. استفاده از خنککنندههای فعال (Active Heatsink) و پایش دما با SMART Attributes — مانند Temperature, Available Spare, Media Wearout Indicator — ضروری است. یک SSD با دمای بالای ۷۰ درجه سانتیگراد، عمرش را تا ۶۰ درصد کاهش میدهد.

یکپارچهسازی با سیستم عامل و فایلسیستم

سیستمهایی مانند Linux با فایلسیستم ZFS، از “L2ARC” (Level 2 Adaptive Replacement Cache) استفاده میکنند که دقیقاً این مدل را پیادهسازی میکند. در مقابل، Windows با ReFS یا NTFS، نیازمند نرمافزارهای شخص ثالث مانند PrimoCache هستند. انتخاب فایلسیستم، نه تنها عملکرد، بلکه قابلیت بازیابی و امنیت را نیز تحت تأثیر قرار میدهد.

راهبرد بازیابی و امنیت داده

حتی اگر حافظه NVMe بهعنوان cache استفاده شود، دادههای اصلی همیشه روی HDD ذخیره میشوند. اما باید از روشهایی مانند RAID 1 برای HDDها، یا از پشتیبانیهای اتوماتیک (snapshots) در ZFS استفاده شود. همچنین، امکان انتقال دستی دادههای حساس از NVMe به HDD با کد احراز هویت (encryption key rotation) ضروری است.

پیادهسازی سیستم caching در NVMe/ یک مثال واضح

در یک مرکز پزشکی دانشگاهی، سیستمهای تصویربرداری پزشکی (MRI, CT) هر روز بیش از ۲ ترابایت داده تولید میکنند. این دادهها در ابتدا روی یک سری NVMe SSDهای ۱ ترابایتی بهعنوان cache ذخیره میشوند. پس از ۳ روز، دادههایی که بیش از ۲ بار بازدید نشدهاند، بهصورت خودکار به یک آرایه ۸ درایو HDD ۱۸ ترابایتی در RAID 6 منتقل میشوند. سیستم از ZFS استفاده میکند و از L2ARC و ZIL (ZFS Intent Log) بهصورت همزمان بهره میبرد.

در این سیستم، پزشکان همچنان با سرعت بالا به آخرین ۱۰۰ تصویر بیماران دسترسی دارند — بدون اینکه چند ثانیه انتظار بکشند. در عین حال، تمامی تصاویر قدیمی — که ممکن است بعد از ۱۰ سال برای تحقیق مجدد نیاز باشند — بهصورت ایمن، با رمزگذاری AES-256، روی HDDها نگهداری میشوند. هزینه سیستم در مقایسه با یک سری SSDهای ۱۰۰ ترابایتی، ۷۵ درصد کمتر بوده است.

این مثال نشان میدهد که caching در NVMe، نه یک انتخاب فنی، بلکه یک انتخاب انسانی است: انتخابی که به پزشکان اجازه میدهد تمرکز خود را بر روی بیماران بگذارند، نه بر روی تأخیرهای سیستمی. این روش، در بیمارستانهای آلمان، ژاپن و کانادا نیز بهصورت استاندارد پیادهسازی شده است.

چالشهای اجرایی سیستم caching و راهکارها

با وجود تمام مزایا، پیادهسازی سیستم caching در NVMe با HDD، چالشهایی دارد که باید با دقت مدیریت شوند:

- عدم هماهنگی بین سختافزار و نرمافزار

بسیاری از سرورهای قدیمی، از کنترلر NVMe پشتیبانی نمیکنند، یا BIOS/UEFI آنها امکان تنظیم L2ARC را ندارد. راهکار: استفاده از سرورهای مدرن با پشتیبانی از PCIe 4.0/5.0 و سیستمعاملهای لینوکس مانند Ubuntu Server 22.04 LTS یا Rocky Linux 9.

- خرابی حافظه NVMe و از دست رفتن دادههای موقت

اگر NVMe بهطور ناگهانی خراب شود، دادههای موقت در cache از بین میروند — اما دادههای اصلی روی HDD باقی میمانند. این یک “فقدان داده موقت” است، نه “فقدان داده دائمی”. راهکار: فعالسازی ZIL (ZFS Intent Log) که تمام نوشتنهای موقت را به HDD انتقال میدهد، حتی قبل از تأیید نهایی.

- عدم آگاهی مدیران از مفهوم “دادههای سرد”

بسیاری از مدیران، همه دادهها را “اهمیت بالا” میدانند. این باور، باعث میشود تمام دادهها روی NVMe نگه داشته شوند — و سیستم را از نظر هزینه نابود کند. راهکار: آموزش تخصصی به تیمهای IT با استفاده از گزارشهای آماری شفاف (مانند نمودارهای دسترسی به داده در Grafana) که نشان میدهد ۹۵ درصد دادهها تنها ۱ بار در سال بازدید میشوند.

- تأخیر در بازیابی دادههای آرشیوی

اگر یک پزشک بخواهد یک تصویر CT از ۷ سال پیش را بازیابی کند، ممکن است چند ثانیه صبر کند. این تأخیر، در یک سیستم با caching در NVMe، بهصورت تدریجی و با اطلاعرسانی به کاربر (مانند “Loading from archive…”) قابل مدیریت است — نه بهصورت یک خطا. راهکار: ایجاد یک “پیشبینی دسترسی” (Predictive Prefetching) که دادههای آرشیوی را قبل از درخواست کاربر، بهصورت پسزمینه به NVMe منتقل کند.

آینده سیستم caching در NVMe چگونه خواهد بود؟

در آینده نزدیک، سیستمهای caching در NVMe دیگر فقط بر اساس LRU یا LFU کار نخواهند کرد. با ظهور الگوریتمهای یادگیری ماشینی (Machine Learning) در سطح کنترلر، این سیستمها قادر خواهند بود الگوهای دسترسی را پیشبینی کنند — بدون نیاز به تنظیم دستی.

مثلاً، یک سیستم میتواند تشخیص دهد که هر سال در ماه مهر، دادههای مالی سال قبل بازدید میشوند — و بهصورت خودکار این دادهها را ۱۰ روز قبل از آن، از HDD به NVMe منتقل کند. یا اینکه، در یک بیمارستان، اگر یک بیمار به بخش اورژانس منتقل شود، تمامی تصاویر قدیمی او — حتی از ۱۰ سال پیش — بهصورت پیشبارگذاری (pre-fetch) به NVMe منتقل شوند. این روند، به “Caching 3.0” معروف میشود: سیستمی که نه فقط دادههای فعال را میشناسد، بلکه آینده را پیشبینی میکند. شرکتهایی مانند Western Digital و Seagate، در حال توسعه فناوریهایی به نام “AI-Driven Storage Tiering” هستند — که این مفهوم را به صورت سختافزاری در SSDهای آینده پیادهسازی خواهند کرد. در این آینده، HDDها دیگر “قدیمی” نخواهند بود — بلکه “هوشمند” خواهند شد. و NVMeها، دیگر فقط “سریع” نخواهند بود — بلکه “پیشبینکننده” خواهند شد.

همچنین مقاله های زیر را مطالعه نمایید:

کلام آخر/ سیستم caching در NVMe- ترکیبی هوشمندانه

سیستم caching در NVMe، نه یک انتخاب فنی، بلکه یک فلسفه مدیریت داده است. این روش، به ما یادآوری میکند که سرعت، همیشه بهترین پاسخ نیست — و پایداری، همیشه بیارزش نیست. با استفاده از NVMe بهعنوان یک لایه هوشمند برای دسترسی فوری، و HDD بهعنوان یک آرشیو بلندمدت و ایمن، ما به یک ترکیب انسانی، اقتصادی و زیستپذیر دست مییابیم. این ترکیب، نه تنها در سرورهای بزرگ، بلکه در کتابخانههای دیجیتال، موزههای آرشیوی، و حتی در خانههای افرادی که عکسهای خانوادگی را ذخیره میکنند، جایگاه خود را پیدا کرده است. و در نهایت به عقیده ایران تک، آرشیو بلندمدت، دیگر یک مفهوم گمشده نیست — بلکه یک هنر تکنولوژیکی است که ما یاد گرفتهایم.

سوالات متداول

آیا استفاده از NVMe بهعنوان cache، عمر HDD را واقعاً افزایش میدهد؟

بله، با کاهش تعداد دسترسیهای مکانیکی، عمر HDD تا ۴۰ درصد افزایش مییابد.

آیا این روش برای خانههای معمولی هم مناسب است؟

بله — بهویژه برای کسانی که فایلهای عکس، فیلم یا اسناد قدیمی دارند و میخواهند سرعت و پایداری را با هزینه کم ترکیب کنند.

آیا این سیستم در ابر (Cloud) پشتیبانی میشود؟

بله — AWS Storage Gateway، Azure Archive Storage و Google Nearline، همگی از این مدل caching در NVMe در سطح edge استفاده میکنند.